Im laufenden Bundestagswahlkampf schaffen es die AfD und ihre Spitzenkandidatin Alice Weidel immer wieder, eine hohe mediale Sichtbarkeit zu erzeugen. Das hängt auch entscheidend mit der prominenten Unterstützung durch den US-Milliardär Elon Musk zusammen. Im folgenden Artikel wird erläutert, wie die kommunikativen Interventionen von Musk die mediale Präsenz von Weidel und der AfD erhöhen und wie diese Dynamiken von Mechanismen der digitalen Aufmerksamkeitsökonomie getrieben werden.

Der Beitrag ist zuerst auf dem Blog des Forschungsinstituts Gesellschaftlicher Zusammenhalt (FGZ) erschienen.

Musk als Taktgeber der öffentlichen AfD-Berichterstattung

„Only the AfD can save Germany“ schrieb der US-amerikanische Milliardär und Berater der neuen Trump-Administration Elon Musk auf seinem Kurznachrichtendienst „X“ im Dezember 2024 mitten in den deutschen Wahlkampf hinein. Musk war zuletzt immer wieder mit radikalen Verschwörungserzählungen, Desinformationen, Beschimpfungen und zunehmend auch kommunikativen Interventionen in das innenpolitische Geschehen in europäischen Ländern wie Großbritannien und Deutschland aufgefallen. Ende Dezember folgte ein Gastbeitrag in der „WELT“, im Januar dann ein Live-Talk mit AfD-Chefin Alice Weidel, den seitdem Millionen Nutzer*innen gesehen haben. Das Gespräch zwischen Weidel und Musk enthielt neben AfD-Wahlwerbung zahlreiche Halbwahrheiten, Falschinformationen und geschichtsrevisionistische Aussagen (Weidel: „Hitler war Kommunist“). Die prominente Unterstützung im Wahlkampf zahlte sich für die Spitzenkandidatin aus, beispielsweise auf der Plattform X, wo Weidels Prominenz im Takt zu Musks digitalen Interventionen in die Höhe schoss (Nenno & Lorenz-Spreen, 2025).

Weidel, Musk und die AfD: X als Sprungbrett in die traditionelle Medienlandschaft

Ähnliche Mitnahmeeffekte lassen sich auch für die breitere deutsche Medienlandschaft beobachten. Bereits die Ankündigung des Gesprächs zwischen Musk und Weidel auf X dominierte die Schlagzeilen großer deutscher Medienhäuser:

Online-Berichterstattungen in traditionellen Medien: Titelseiten von BILD, SPIEGEL, taz und DIE ZEIT

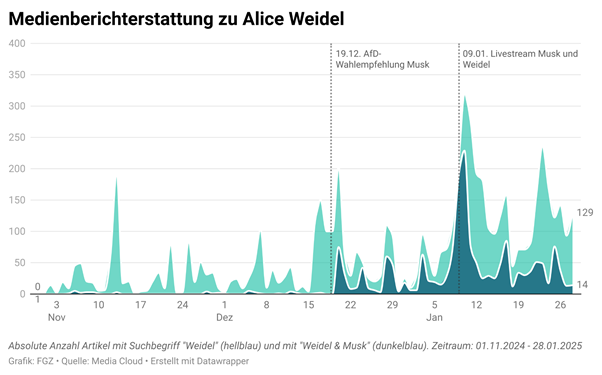

Eine quantitative Kurzanalyse deutschsprachiger Online-Medienartikel mit dem Analyse-Tool Media Cloud (siehe methodische Anmerkungen am Ende) bestätigt, dass die Interventionen von Musk zu einem deutlichen Sichtbarkeitsschub für AfD-Spitzenkandidatin Weidel beigetragen haben. Der Anteil an Medienbeiträgen mit den Begriffen „Weidel“ und „Musk“ (dunkelblau) im Verhältnis zu Artikeln, die lediglich den Begriff „Weidel“ (hellblau) erwähnten, stieg rund um den Wahlaufruf (20.12.: 37 %), den WELT-Beitrag (28.12.: 55 %) und dem X-Talk (09.01.: 91 %) deutlich an.

Am offensichtlichsten wurde der Zusammenhang in der Woche rund um das X-Gespräch von Weidel und Musk. Am 09.01. verzeichnete MediaCloud die bis dato höchste Anzahl an Artikeln mit dem Begriff Weidel (205 Artikel), von denen ganze 186 ebenfalls Musk erwähnten. Über die Woche vom 06.01. bis 12.01. hinweg schoss die Anzahl von Artikeln, die Weidel erwähnten auf eine im Untersuchungszeitraum einmalig hohe Zahl von 1.243 Artikeln.

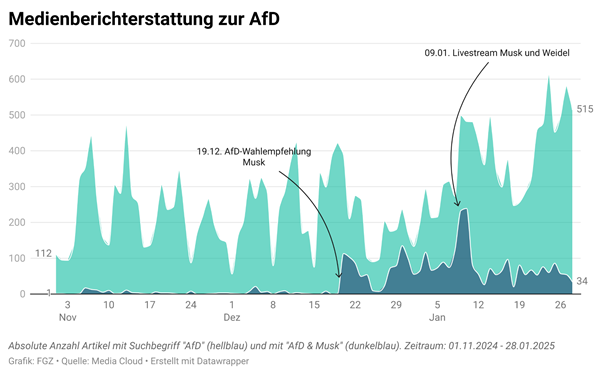

Verwenden wir statt „Weidel“ den Suchbegriff „AfD“, so zeigt sich, dass sich die Mitnahmeeffekte bisher stärker auf die Person und weniger auf die Partei insgesamt auszuwirken scheinen, wenngleich auch dort moderatere Effekte rund um die Schlüsselereignisse sichtbar werden.

Die digitale Aufmerksamkeitsökonomie als Grundlage hyper-salienter Rechtsaußen-Kommunikation

Dem Anstieg dieser medialen Sichtbarkeit der radikalen Rechten liegen Dynamiken zugrunde, die exemplarisch für die Transformation der diskursiven Machtstrukturen in der digitalen Öffentlichkeit stehen: Digitale Medien eröffnen Akteur*innen jenseits der tradierten politischen Landkarte (etwa Musk, AfD, Weidel) einen kommunikativen Möglichkeitsraum, in dem sie sowohl ohne Umweg über die Medien direkt mit ihren Unterstützer*innen kommunizieren (nach innen gerichtete Kommunikation), als auch substanziell den öffentlichen Diskurs beeinflussen können (nach außen gerichtete Kommunikation). Letzteres ist Ausdruck des gegenwärtigen hybriden Mediensystems, in dem sich digitale und traditionelle Medien verbinden und gegenseitig beeinflussen. Grundlegend für diese Mechanismen ist insbesondere die digitale Aufmerksamkeitsökonomie. Hier konkurrieren politische und mediale Akteur*innen sowie digitale Plattformen um die Aufmerksamkeit der Medienkonsument*innen, um ihre Botschaften zu kommunizieren und Werbeeinnahmen zu generieren. Da die Menge an verfügbaren Informationen im Kontext digitaler Medien dramatisch gestiegen ist, die verfügbare menschliche Aufmerksamkeit jedoch gleichgeblieben ist, hat die Kompetitivität in der digitalen Aufmerksamkeitsökonomie deutlich zugenommen. Noch mehr als zuvor gewinnen kommunikative Strategien an Bedeutung, die es ermöglichen, sich in dieser Umgebung durchzusetzen.

Provokation als strategisches Mittel des Agenda Setting und Hackings

Die radikale Rechte scheint sich den Eigenlogiken der digitalen Aufmerksamkeitsökonomie stärker bewusst zu sein als andere Akteur*innen und bearbeitet sie strategisch. So handelte es sich bei der prominenten Unterstützung der AfD im Bundestagswahlkampf durch Elon Musk um eine besonders gelungene Form des Agenda Settings, das die mediale Sichtbarkeit von Weidel und der AfD substanziell erhöhte. Weidels geschichtsrevisionistische Aussage zu Hitler und dem Nationalsozialismus lag wohl unter anderem ein strategisches Interesse der weiteren Verschiebung der „Grenze des Sagbaren“ und der Normalisierung rechtsextremer Narrative zugrunde. Allerdings schien die Aussage eben insbesondere auch als eine bewusste Provokation platziert, von der Weidel sich sicher sein konnte, damit entsprechende mediale Beachtung zu erzielen und ihre eigene Sichtbarkeit im limitierten Aufmerksamkeitsraum der öffentlichen Arena zu erhöhen.

Das Prinzip der Aufmerksamkeitsgewinnung durch gezielte und strategisch platzierte Provokationen hat US-Präsident Donald Trump bereits in den vergangenen Jahren mit großem Erfolg angewandt. Schon während der republikanischen Kandidatenkür im Vorfeld der Präsidentschaftswahl 2016 konnte Donald Trump unter anderem durch gezielte Norm- und Tabubrüche einen überproportionalen Teil der medialen Aufmerksamkeit auf sich lenken. Dies trug dazu bei, dass er sowohl die Vorwahlen als auch die Präsidentschaftswahl für sich entscheiden konnte (Schroeder 2018, Wells et al. 2016). Steve Bannon, ehemaliger Wahlkampfmanager Trumps und Mitgründer des rechtsextremen Portals „Breitbart“, beschrieb den Grundsatz der kommunikativen Strategie der ersten Trump Administration mit den Worten: „Flood the Zone with Shit“. Entscheidend für die Bewertung des Erfolgs dieser Strategie ist in dieser Lesart allein die mediale Sichtbarkeit. Der Wahrheitsgehalt der eigenen Äußerungen und die Frage, ob eine eher positive oder eher negative öffentliche Berichterstattung über die Äußerungen erfolgt, spielen im Zweifelsfall keine wesentliche Rolle. Denn für die positive Rezeption des Gesagten sorgen letztendlich die (digitalen) Kommunikationskanäle des unterstützenden politischen Lagers, deren Reichweite durch die geschilderte Strategie stetig erweitert wird.

Radikal rechte (digitale) Dauerbeschallung: DDoS Attacks on our minds

Entscheidend für diese Strategie ist, dass der politischen Gegenseite die Möglichkeit genommen wird, selbst in Erscheinung zu treten oder eigene Themen zu setzen. Stattdessen arbeiten sie sich, genauso wie Medien und Presse, an den von der radikalen Rechten gesetzten Themen und Narrativen ab und setzen kaum noch eigene Themen. Die US-amerikanische Journalistin Julia Angwin bezeichnet diese Strategie des Agenda Settings durch konstante Tabubrüche und Provokationen als „DDoS attack on our minds“. DDoS Attacken (Distributed Denial-of-service attack) ist eigentlich ein Begriff aus der Cybersicherheit und beschreibt die Überwältigung der Bereitstellung eines Webservices (z.B. einer Webseite) durch eine Flut an (Fake-)Abrufanfragen. Übertragen auf die Strategie der AfD und die wirkmächtige Unterstützung von Elon Musk, lässt sich diese Form des Agenda Settings als eine systematische Überforderung des politischen Willensbildungsprozesses bezeichnen. Die Diskurs- und Informationspraktiken, die der politischen Willensbildung zugrunde liegen, werden durch ständige, inhaltlich oft leere und provokative Vorstöße unterminiert. Die Funktionalität des politischen Willensbildungsprozesses selbst scheint auf lange Sicht hierdurch grundsätzlich gefährdet.

Debatte über den Umgang mit den radikal rechten Diskursstrategien

Welche konkreten Auswirkungen die beschriebenen Geländegewinne im öffentlichen Diskurs konkret auf den Ausgang der Bundestagswahl 2025 haben werden, ist zum jetzigen Zeitpunkt schwer einzuschätzen. Die Befunde der Kurzanalyse illustrieren exemplarisch, wie schnell sich öffentliche Diskurse im Windschatten der globalen politischen Ereignisse aus den sozialen Medien heraus kapern lassen. Und sie zeigen, wie fließend die Grenzen zwischen radikalen digitalen „fringe communities“ und tradierten öffentlichen Diskursräumen mitweilen sind.

Dabei bestehen durchaus politische und mediale Handlungsspielräume, um den genannten Entwicklungen etwas entgegenzusetzen. Der europäische Digital Services Act (DSA) bietet, ebenso wie der im August 2024 EU-weit beschlossene AI Act, vielfältige Interventionsmöglichkeiten. Insbesondere bietet der weitgefasste Begriff der systematischen Risiken für die gesellschaftliche Debatte, auf Wahlprozesse und für die öffentliche Sicherheit (Art. 34, 35 DSA) Anknüpfungspunkte, um gegen die beschriebenen Dynamiken einer digitalen Aufmerksamkeitsökonomie vorzugehen. Wegen des Live-Talks von Musk und Weidel haben die Bundestagsverwaltung und die EU Überprüfungen angekündigt. Gegen einige große Plattformbetreiber laufen schon seit längerem DSA-Verfahren. Bezogen auf die öffentlichen Debatten im Wahlkampf liegt ein wesentlicher Teil der Entscheidungshoheit über die Art und Weise der Berichterstattung bei den privaten Medienhäusern und öffentlich-rechtlichen Rundfunkanstalten, auch wenn das hybride Mediensystem und die digitale Aufmerksamkeitsökonomie hier erhebliche Fliehkräfte erzeugen. Eine vielfältige, umfangreiche und aufgeklärte Berichterstattung rund um die AfD erscheint – gerade unter den Bedingungen eines polarisierten Wahlkampfes – notwendig. Allerdings kann eine mediale Dauerpräsenz auch unerwünschte Nebeneffekte haben, die den Diskursstrategien von Rechtsaußen mehr nutzen als schaden. Angesichts der politischen und medialen Raumgewinne der globalisierten radikalen Rechten ist eine fortgesetzte gesamtgesellschaftliche Debatte darüber notwendig, zu welchen Anlässen, in welchem Umfang und in welcher Form dem digitalen Dauerfeuer der radikalen Rechten Raum gegeben werden sollte.

Methodische Anmerkungen

MediaCloud ist eine Open-Source-Analyseplattform für Online-Medienberichterstattung. Die Plattform sammelt Online-Medienartikel, bereitgestellt durch die RSS-Feeds von Medienwebseiten. Unserer Analyse liegt eine Kollektion von 257 Medienwebseiten aus Deutschland zugrunde, deren Berichterstattung im Zeitraum 01.11.24 bis 28.01.25 mit den ausgeführten Keywords gefiltert wurde. Nicht alle Artikel, die von den Keywörtern erfasst und in die oben dargestellten Grafiken eingespielt wurden, haben Musk, Weidel oder die AfD als Hauptthema. Eine stichprobenartige manuelle Validierung bestätigt jedoch, dass die Artikel im Wesentlichen die Medienberichterstattung über die genannten Akteur*innen abdecken.

Literatur

Franck, G. (1998). Ökonomie der Aufmerksamkeit: Ein Entwurf (12. Auflage). Edition Akzente. Carl Hanser Verlag.

Nenno, S. & Lorenz-Spreen, P. (2025). Do Alice Weidel and the AfD benefit from Musk’s attention on X? Alexander von Humboldt Institute for Internet and Society. https://www.hiig.de/en/musk-x-and-the-afd/ https://doi.org/10.5281/ZENODO.14749544

Schroeder, R. (2018). Social Theory after the Internet: Media, Technology, and Globalization. UCL Press. https://doi.org/10.2307/j.ctt20krxdr

Wells, C., Shah, D. V., Pevehouse, J. C., Yang, J., Pelled, A., Boehm, F., Lukito, J., Ghosh, S., & Schmidt, J. L. (2016). How Trump Drove Coverage to the Nomination: Hybrid Media Campaigning. Political Communication, 33(4), 669–676. https://doi.org/10.1080/10584609.2016.1224416

Titelbild: iStock, Credit: da-kuk